苹果公司与芬兰阿尔托大学合作开展的新研究推出了ILuvUI模型:这是一个通过截图和自然语言对话训练、专为理解移动应用界面设计的视觉语言模型。以下是其原理与实现方式。

ILuvUI:性能超越基础模型的AI系统

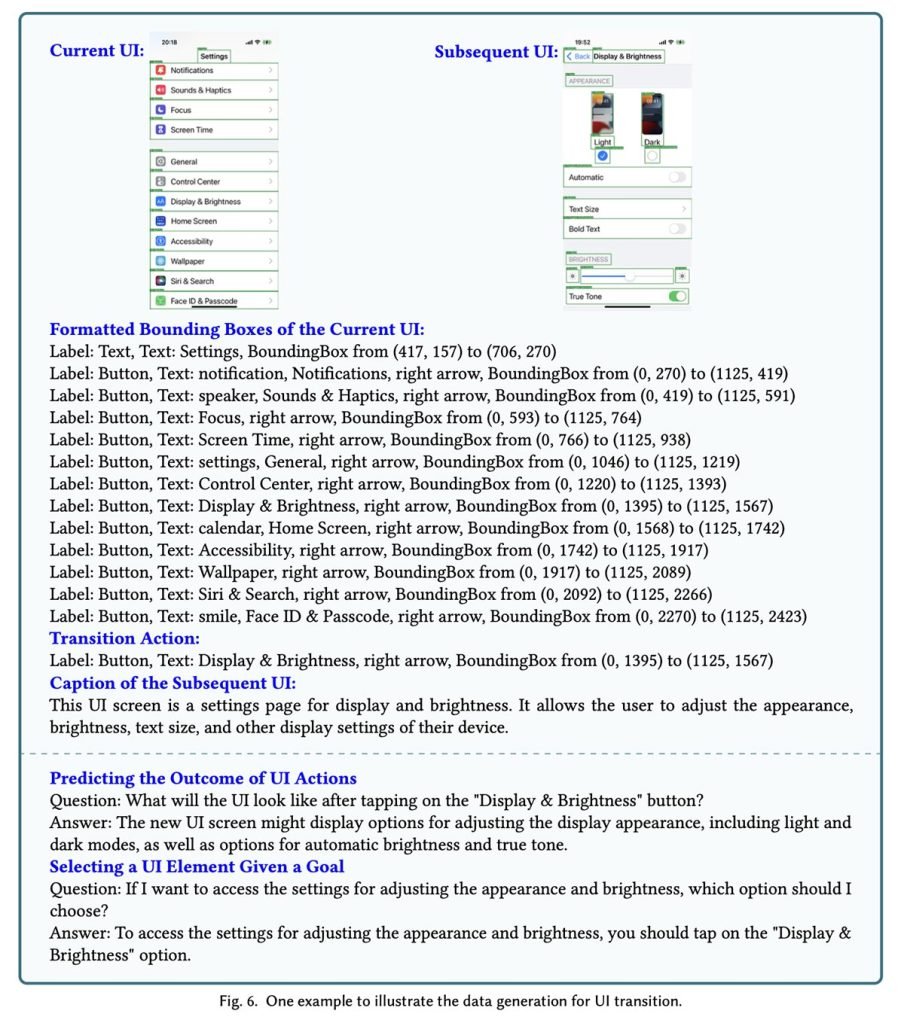

在论文《ILuvUI:基于机器对话的UI视觉语言指令调优模型》中,研究团队攻克了人机交互领域长期存在的难题——教会AI模型像人类一样理解用户界面,即同时具备视觉解析和语义推理能力。

“理解并自动化操作UI界面具有挑战性,因为屏幕中的列表项、复选框、文本字段等元素包含多层信息,远超其基础交互功能。(…) 虽然大语言模型在自然语言指令理解方面表现卓越,但仅依靠文字描述会丢失UI丰富的视觉信息。”

研究人员指出,当前多数视觉语言模型的训练数据是自然图像(如动物或街景),导致其解析结构化应用界面时表现欠佳:

“融合视觉与文本信息对UI理解至关重要,这符合人类认知方式。视觉语言模型(VLM)虽能处理图像文本多模态输入,但由于训练数据缺乏UI案例,其在界面任务上的表现远逊于自然图像场景。”

基于此,团队对开源VLM模型LLaVA进行微调,并改进其训练方法使其专精UI领域。

经专项数据集训练后,ILuvUI模型在机器基准测试和人类偏好评估中均超越原始LLaVA模型。

该模型无需用户指定界面关注区域,仅通过简单提示即可理解完整屏幕上下文:

ILuvUI (…) 无需预设关注区域,在接收UI图像的同时接受文本提示输入,使其能够胜任视觉问答等应用场景。

实际应用价值

苹果研究人员表示,该技术有望提升无障碍访问体验和自动化UI测试效率。尽管ILuvUI仍基于开源组件,未来可能采用更大图像编码器、优化分辨率处理,以及适配JSON等现有UI框架的输出格式。

若结合苹果近期关于AI预测应用操作后果的研究,这项技术将展现出更大潜力——无论是助力残障用户操作设备,还是自动处理应用流程中的复杂环节,都可能带来革命性改变。