有一个新的苹果的研究论文正在流传,如果你看到了人们的反应,你会认为它刚刚颠覆了整个法学硕士行业。这远非事实,尽管这可能是将机器学习社区多年来一直在进行的讨论带入主流的最佳尝试。这就是为什么这篇论文很重要。

所讨论的论文,思维的幻觉:从问题复杂性的角度理解推理模型的优缺点,当然很有趣。它使用受控谜题(河内塔、Blocks World等)系统地探索所谓的大型推理模型(LRM),如Claude 3.7和DeepSeek-R1,而不是经常受到数据污染的标准数学基准。

结果如何?LRM在中等复杂度的任务上比LLM做得更好,但在更复杂的任务上同样难以崩溃。更糟糕的是,随着任务变得越来越难,这些“推理”模型开始思考得更少,而不是更多,即使它们还有象征性的预算可以腾出。

但是,尽管这篇论文成为头条新闻,好像它只是揭露了一些深层次的秘密,但我认为:这些都不是新的。现在它更清晰了,更容易让广大公众理解。事实上,这是个好消息。

论文显示了什么

头条新闻是,为“推理”而营销的模型在耐心的孩子可以掌握的问题上仍然失败。例如,在河内塔,像克劳德和o3 mini这样的模型在七八个圆盘后就会倒塌。即使给出精确的求解算法并要求简单地遵循它,性能也不会提高。

换句话说,它们不是推理,而是以更精细的方式迭代扩展LLM推理模式。这种区别很重要,这就是苹果论文的真正价值。作者们正在推翻像“推理”和“思考”这样的负载术语,这些术语建议符号推理和规划,而实际发生的事情只是一个分层模式扩展:模型运行多个推理过程,直到它落在听起来合理的东西上。

这并不完全是一个启示。Meta的人工智能主管Yann LeCun长期以来相比今天的LLMs都是“家猫”,并一直表示AGI不会来自《变形金刚》。Subbarao Kambhampati多年来,已经发表了关于“思维链”与这些模型实际计算方式不符的文章。和盖瑞·马库斯好吧,他长期以来的“深度学习正在碰壁”论文又增添了一笔。

模式匹配,而不是解决问题

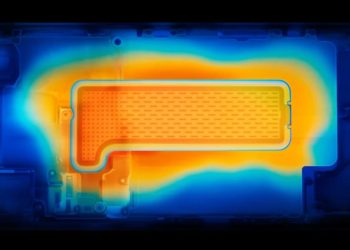

这项研究最糟糕的数据点可能是:当复杂性增加时,模型实际上会停止尝试。尽管还有大量的计算预算,但随着挑战的扩大,他们会减少自己的内部“思维”。这不仅仅是一个技术上的失败,更是一个概念上的失败。

苹果的论文有助于澄清的是,许多LLM之所以失败,并不是因为它们“训练不够”或“只是需要更多数据”。它们失败是因为它们从根本上缺乏一种表示和执行逐步算法逻辑的方法。而这并不是思维链的提示或强化微调可以强行消除的东西。

引用这篇论文本身的话:“LRM无法在谜题中使用明确的算法和不一致的推理。”即使交给他们一份解决方案蓝图,他们也会跌跌撞撞。

那么…这是坏消息吗?

对。只是没有新新闻。

对于深入机器学习研究社区的人来说,这些结果并不令人惊讶。但它们引发的轰动突显了一件更有趣的事情:令人震惊的公众可能终于准备好应对机器学习世界多年来所做的区分,特别是围绕这些模型可以和不能同上

这种区别很重要。当人们称这些系统为“思考”时,我们开始把它们当作可以取代目前无法完成的事情来对待。这时,幻觉和逻辑失败从有趣的怪癖变成了危险的盲点。

这就是为什么苹果的贡献很重要。不是因为它“暴露”了LLM,而是因为它有助于更清楚地划分它们是什么和不是什么。早就应该明确这一点了。