今年的第一条WWDC公告表明,历史性地,第三方开发者终于可以…直插进去苹果公司推出了新的基础模型框架,并在设备端实现了AI,但这些模型到底和现有的有什么不同呢?

基于最新的模型架构,第三方开发者现在能够利用苹果原生应用所使用到的一同设备上的AI堆叠进行开发。

换句话说,这意味着开发人员现在可以完全在离线环境中集成诸如摘要文档、从用户文本中提取关键信息或甚至生成结构化内容等AI功能,并且无需任何API成本。

但苹果的机型真正有多好?

竞争的地方在哪里都很重要

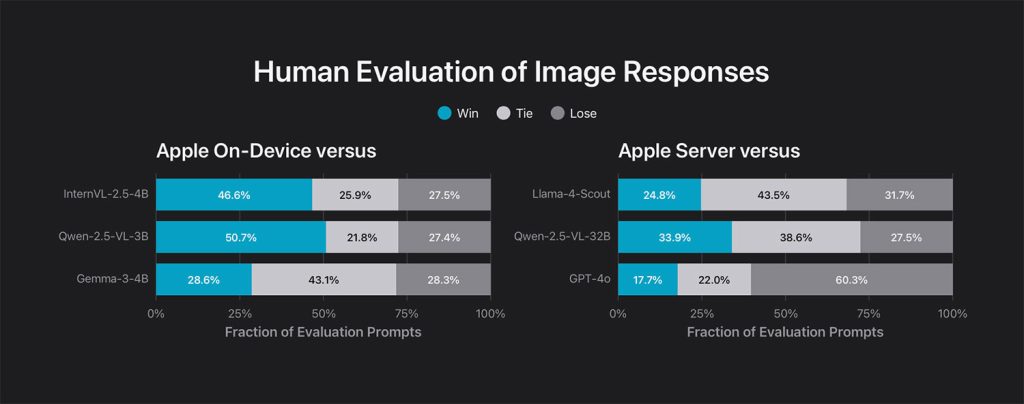

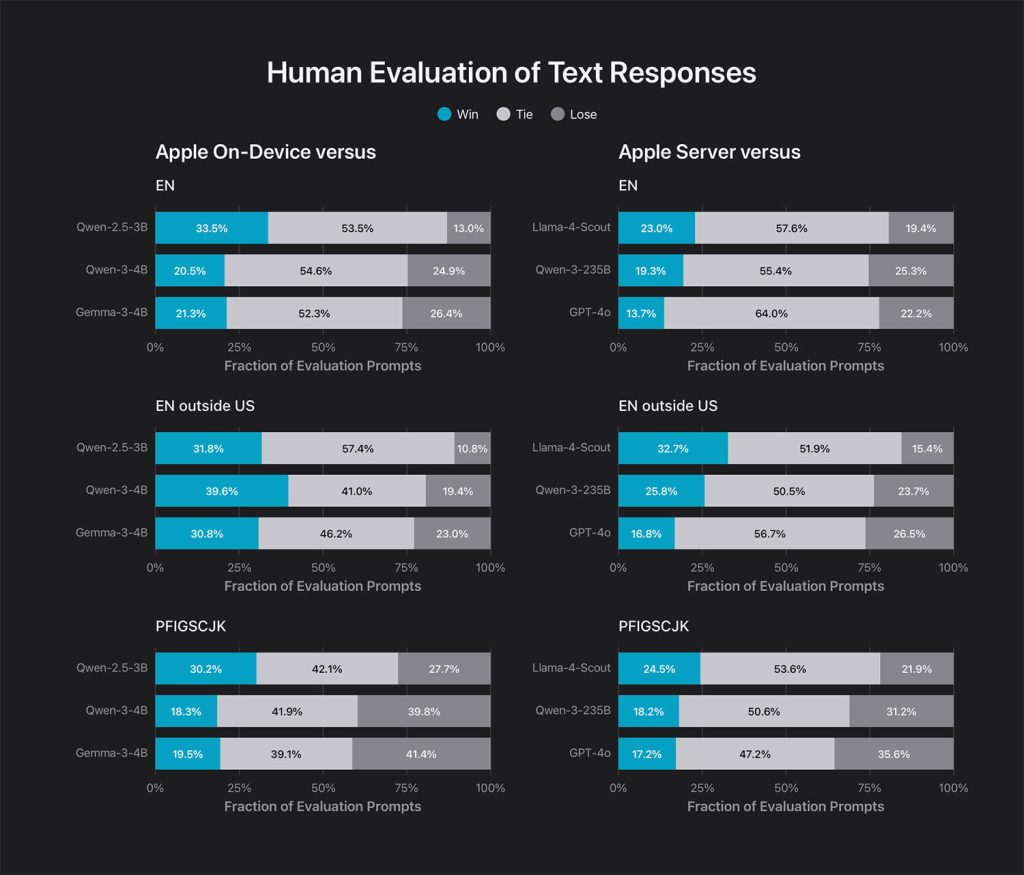

基于苹果自己的人类评价答案是相当稳定的,尤其是当你考虑到大小、速度和效率之间的平衡(有些人可能会称其为“权衡”)时。

在苹果的测试中,其 ~3B 在线模型在图像任务中超越了 InternVL-2.5 和 Qwen-2.5-VL-3B 等轻量级视觉语言模型,分别赢得了 46% 和 50% 的提示。

在文本中,它也与Gemma-3-4B等大型模型对抗,在一些国际英语地区以及葡萄牙语、法语、日语等多语言评估中甚至 slight outperformed。

换句话说,苹果的新本地模型似乎在无需上云或要求数据离开设备的情况下,可以为许多实际用途提供一致的结果。

关于苹果的服务器模式(不向第三方开发者(如本地模型)提供访问权限),与LLaMA-4-Scout相比优势明显,甚至在图像理解方面超越了Qwen-2.5-VL-32B。但无论如何,GPT-4o仍然稳居榜首。

“免费和离线”这部分真的很重要

这里真正的故事不只是说苹果的新款产品性能更好。更重要的是,它们是内置的。借助基础模型框架,开发者无需在应用中集成重大的语言模型以进行离线处理。这意味着应用程序更加精简,在大多数任务上无需依赖云端。

结果是:为用户提供更私密的体验,并且无需任何开发者支付API费用,这些节省最终能惠及所有人。

苹果表示,这些模型经过优化,能够生成结构化输出,并采用了一个Swift原生的“引导生成”系统。这对于教育、生产力和沟通等应用来说,可能是一个重大转折点——它无需像大语言模型(LLMs)那样面对延迟、成本或隐私问题,却能提供类似的优势。

最终,苹果的设备并不是世界上最强大的,但它们不需要。它们很棒、运行速度快,并且现在每个开发者都可以免费使用,在设备上运行以及离线也能使用。

这可能不会与更强大的人工智能模型一样登上头条新闻,但在实践中,它可能会导致一系列真正有用的第三方iOS应用中的人工智能功能,这些功能不需要依赖云端。对苹果来说,这或许是他们想要达到的目的。