关于苹果将推出配备摄像头的可穿戴设备的传闻从未间断。尽管人们已对即将涌现的新一波AI硬件感到审美疲劳,但有一个重要应用场景常被忽视:无障碍辅助功能。

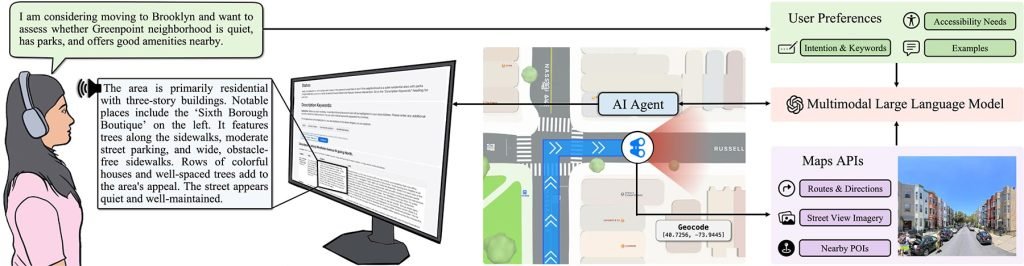

SceneScout是苹果与哥伦比亚大学联合研发的实验性项目,目前虽非可穿戴设备,却揭示了AI为视障群体带来的潜在突破。研究人员这样阐述:

视障人士(BLV)常因对环境布局的不确定而怯于独自探索陌生区域。现有导航工具多聚焦实时指引,出行规划功能则仅提供地标与转向提示,缺乏细节视觉信息。蕴含丰富环境数据的街景图像,对视障群体仍存在使用壁垒。

为消除这一障碍,研究团队通过整合苹果地图API与多模态大语言模型,开发出可交互的AI街景描述系统。

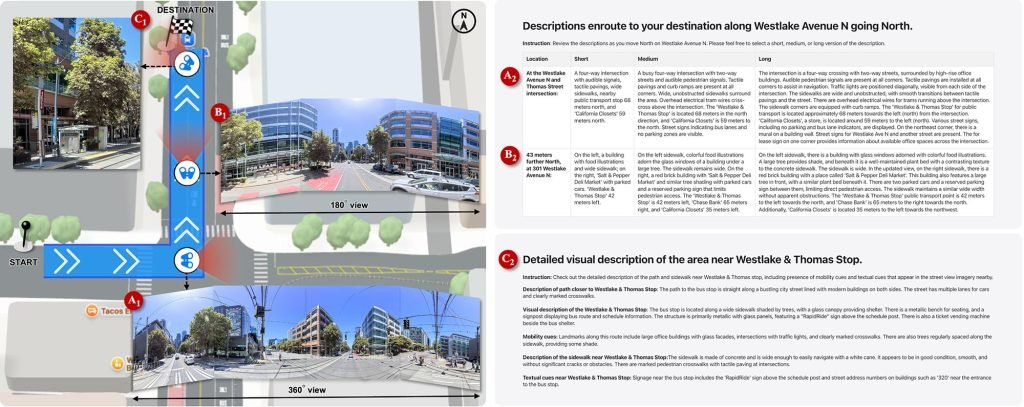

用户不仅能获取转向导航,还可通过定制化的街道级描述,完整预览路线或虚拟探索社区每个角落。

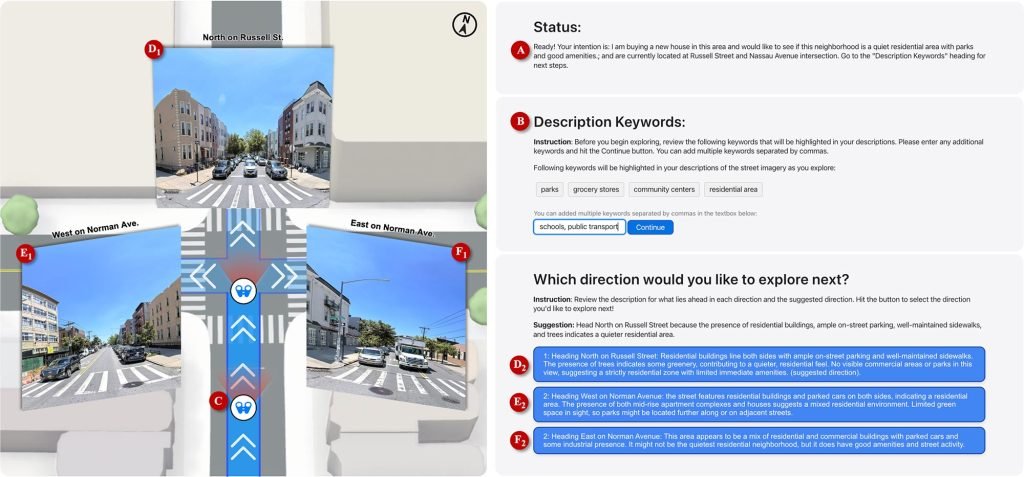

系统具备两大核心功能:

- 路线预览:感知沿途细节,包括人行道状况、交叉路口、标志性建筑、公交站特征等

- 自由探索:用户描述需求(如”带公园的安静住宅区”),AI根据意图提供多方向导航建议

技术层面,SceneScout将基于GPT-4o的智能体嵌入苹果地图实景数据,通过模拟行人视角生成短/中/长三种结构化描述,所有信息均以无障碍网页界面呈现。

初期测试:希望与隐患并存

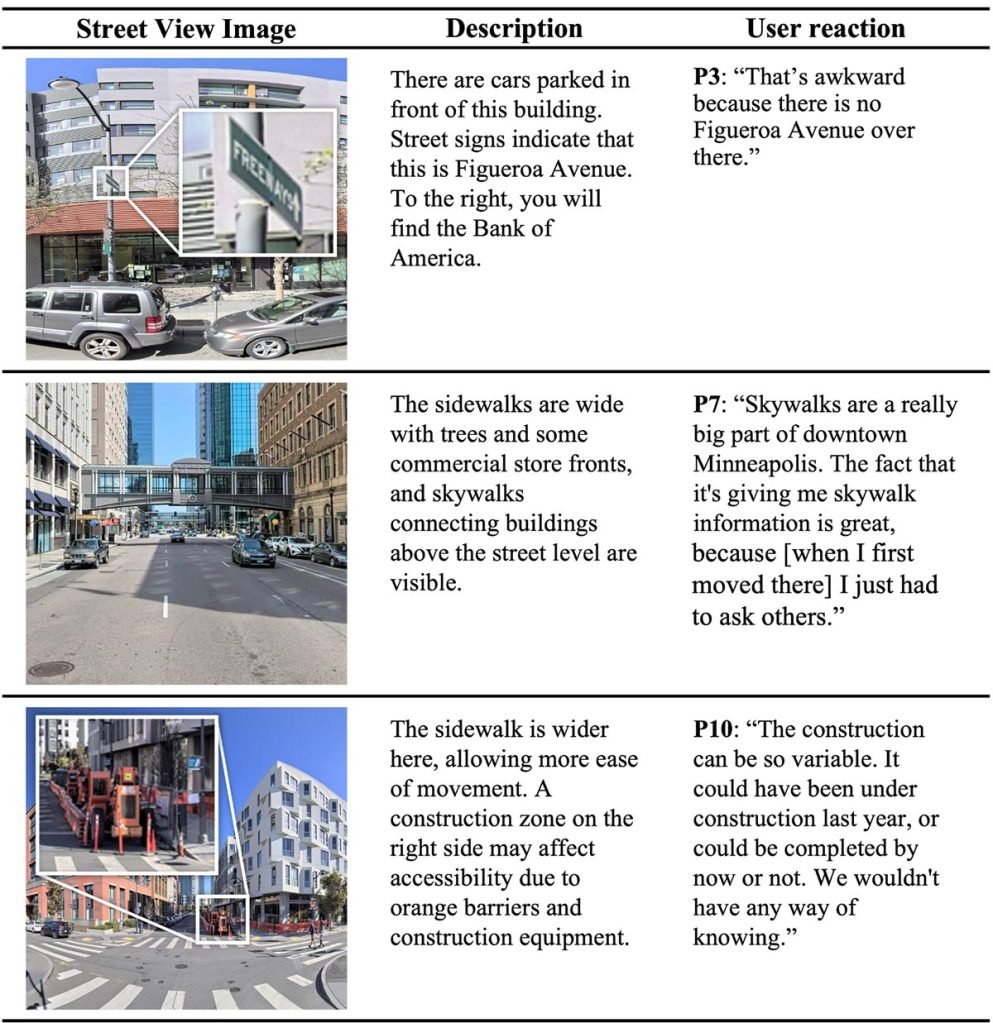

针对10位精通辅助科技的视障用户的测试显示:

虚拟探索功能最受好评,72%的AI描述准确有效。但系统存在将无声人行道误报为有声提示、错误标识路牌等”幻觉”问题,部分描述还引用了临时施工区等非持久性信息。

测试者特别指出:系统有时会预设用户身体能力,空间定位精度有待提升,期待能根据使用习惯动态优化,而非依赖固定关键词。

虽然当前方案尚未实现基于计算机视觉的实时导航,但研究尾声提出的设想颇具前瞻性:

“地图为何不能自动播报周边详情?”(P9用户)

行进时采用精简版播报,遇路口暂停时触发详细描述(P1建议)

通过设备指向获取环境解说,无需精确对准摄像头(P4构想)

这项发布于arXiv平台、题为《SceneScout:AI智能体驱动的视障用户街景访问方案》的研究虽未经同行评审,但为AI+可穿戴设备+计算机视觉的未来发展提供了重要参考。