苹果机器学习研究博客上的一篇新文章展示了,在运行本地大语言模型时,M5苹果芯片相比M4有了多大提升。详情如下。

背景信息

几年前,苹果发布了MLX,该公司将其描述为“一个用于在苹果芯片上进行高效灵活机器学习的数组框架”。

实际上,MLX是一个开源框架,借助AI领域熟悉的API和接口,帮助开发者在他们的苹果芯片Mac上原生构建和运行机器学习模型。

以下是苹果对MLX的进一步说明:

MLX是一个开源数组框架,高效、灵活,并针对苹果芯片进行了深度优化。您可以将MLX用于从数值模拟、科学计算到机器学习的各种应用。MLX内置了对神经网络训练和推理的支持,包括文本和图像生成。MLX使得在苹果芯片设备上使用大语言模型生成文本或进行微调变得容易。

MLX利用了苹果芯片的统一内存架构。MLX中的操作可以在CPU或GPU上运行,而无需移动内存。其API紧密遵循NumPy,既熟悉又灵活。MLX还提供了更高级别的神经网络和优化器包,以及用于自动微分和图优化的函数变换。

目前可用的MLX包之一是MLX LM,旨在用于在苹果芯片Mac上生成文本和微调语言模型。

通过MLX LM,开发者和用户可以下载Hugging Face上的大多数模型,并在本地运行它们。

该框架甚至支持量化,这是一种压缩方法,可以使大模型在占用更少内存的情况下运行。这带来了更快的推理速度,推理基本上是指模型对输入或提示生成答案的步骤。

M5 对比 M4

在其博客文章中,苹果展示了新款M5芯片在推理性能上的提升,这得益于芯片全新的GPU神经引擎,苹果称其“提供了专用的矩阵乘法运算,这对许多机器学习工作负载至关重要。”

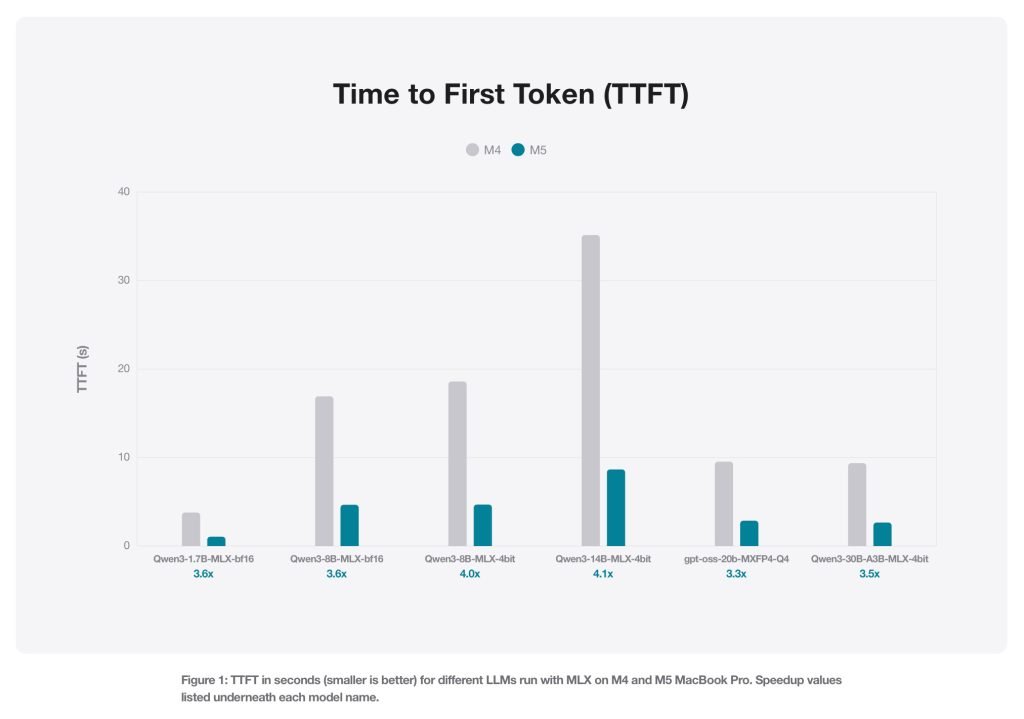

为了说明性能提升,苹果比较了在搭载M4和M5的MacBook Pro上,使用MLX LM,多个开源模型在接收到提示后生成第一个词元所需的时间。

或者,正如苹果所述:

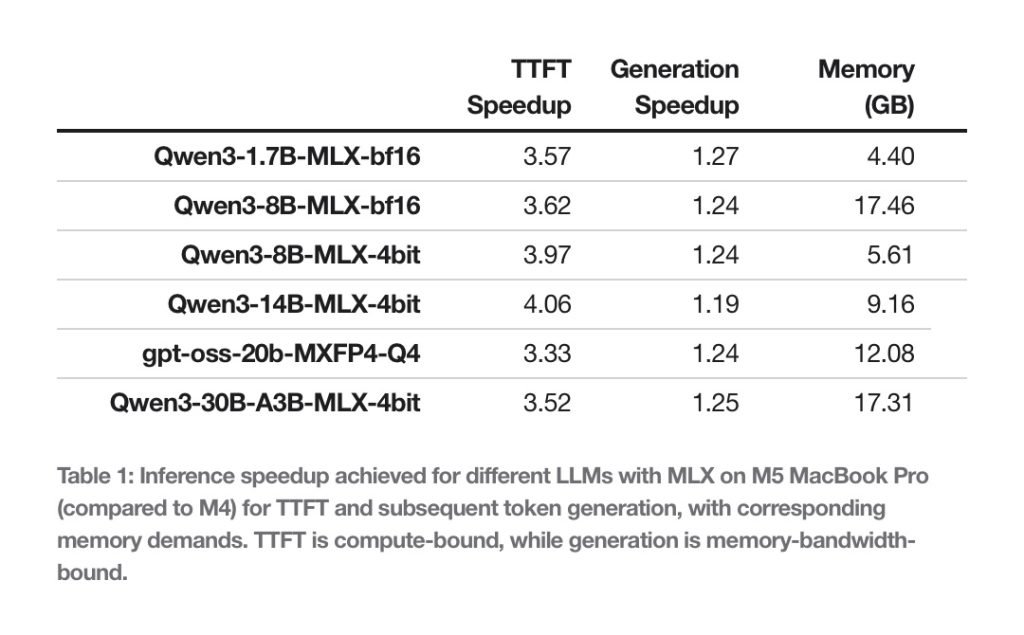

我们评估了原生BF16精度的Qwen 1.7B和8B模型,以及4位量化的Qwen 8B和Qwen 14B模型。此外,我们还对两个专家混合模型进行了基准测试:Qwen 30B和GPT OSS 20B。评估使用mlx_lm.generate进行,并报告首次词元生成时间和生成速度。在所有基准测试中,提示大小为4096。生成速度是在生成128个额外词元时测量的。

结果如下:

这里一个重要的细节是,LLM推理生成第一个词元所采用的方法与生成后续词元的方法不同。简而言之,第一个词元的推理受计算能力限制,而后续词元的生成则受内存带宽限制。

这就是为什么苹果也评估了生成128个额外词元的速度。总体而言,M5相比M4显示出19-27%的性能提升。

苹果对这些结果的评论如下:

在本文测试的架构上,得益于其更高的内存带宽,M5相比M4提供了19-27%的性能提升。关于内存占用,配备24GB内存的MacBook Pro可以轻松容纳一个BF16精度的8B模型或一个4位量化的30B MoE模型,使得这两种架构下的推理工作负载内存占用均低于18GB。

苹果还比较了图像生成的性能差异,并表示M5完成工作的速度比M4快了3.8倍以上。

您可以在此处阅读苹果的完整博客文章,并在此处了解更多关于MLX的信息。