本周,OpenAI发布了备受期待的开源权重模型gpt-oss。该模型的亮点在于支持在本地硬件(包括苹果芯片Mac)上运行。以下是具体操作指南和注意事项。

模型与Mac适配

gpt-oss提供两种规格:20b参数的轻量版和120b参数的重量版。前者是中等规模的开源模型,后者则属于大型开源模型。

配备充足资源的苹果芯片Mac可本地运行轻量版模型。需注意的是,由于训练数据量差异,较小模型可能出现更多幻觉现象,这是换取本地运行速度必须接受的折衷方案。

尽管如此,对于拥有高性能Mac且希望探索大语言模型本地运行的用户而言,这个免费的小型模型仍是不错的工具。

需注意本地模型与ChatGPT的差异:开源模型默认不具备现代聊天机器人的诸多功能,例如响应时不会参考网络搜索结果来减少幻觉。

OpenAI建议至少16GB内存运行gpt-oss-20b,更大内存表现更佳。早期用户反馈表明16GB仅是体验门槛(这也是苹果近期停售8GB内存Mac的重要原因)。

安装与使用

操作流程非常简单:

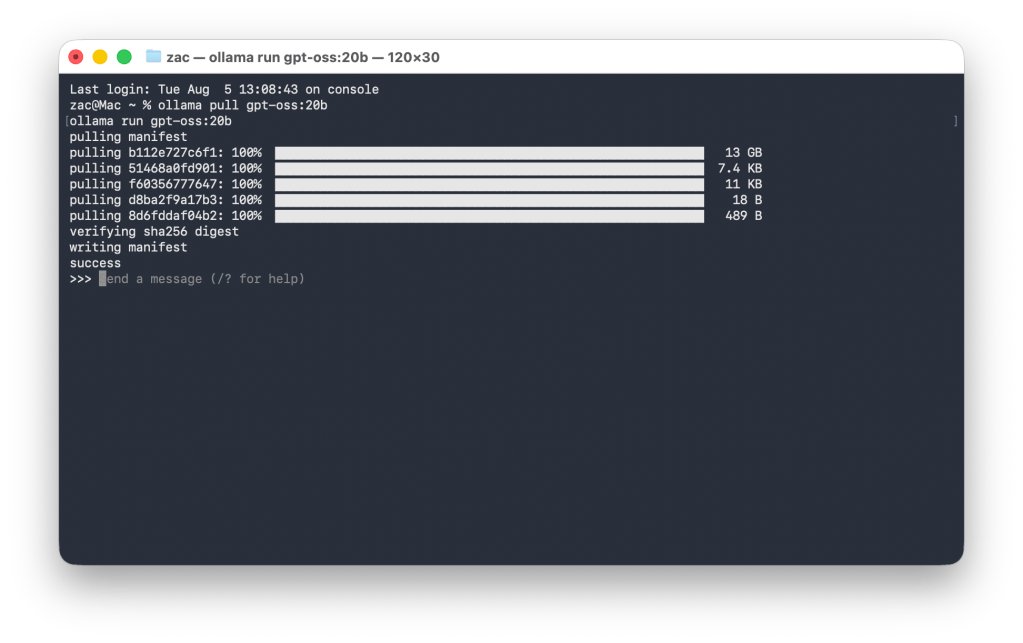

首先在Mac安装Ollama(访问ollama.com/download或直接下载Mac版),这是运行gpt-oss-20b的接口工具。

接着在终端执行命令:

ollama pull gpt-oss:20b

ollama run gpt-oss:20b

这将下载约15GB存储空间的模型文件。

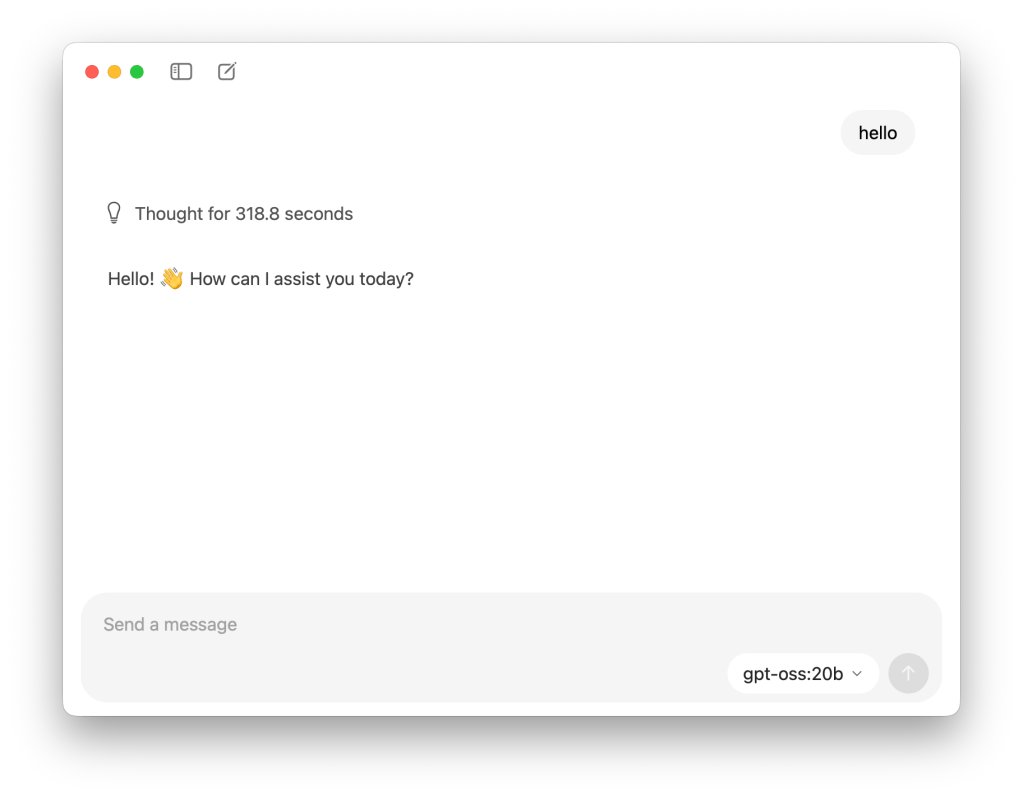

启动Ollama后选择gpt-oss-20b模型,还可在设置中启用飞行模式确保完全本地运行(无需登录)。

在文本框输入指令即可测试模型,性能取决于硬件配置。运行期间Ollama会占用大量资源,可能导致系统卡顿。

实测显示:16GB内存的M4 MacBook Air响应”你好”需5分钟,回答”美国第13任总统是谁”耗时约43分钟。建议计划深度体验的用户配置更大内存。

如需删除模型释放空间,执行终端命令:

ollama rm gpt-oss:20b

更多使用指南可参考官方文档,也可选择LM Studio等其他Mac端AI模型工具。