苹果WWDC25开发者会议充满了有趣的片段,这些细节在主演讲或国会议题展示中得不到展示时间。其中一个特别的片段在某个环节得到了简要介绍。SwiftUI 2.0的最新进展是什么?, 可以提供一个明确的方向性提示。

几个月前彭博‘s的马尔·朱曼报告的那我按要求完成任务了。

在开发中的另一副耳机可能会更吸引人。今年1月,我报道称,苹果放弃了 AR 防弹头眼镜的研发,这些眼镜将连接到一台Mac上。相反,它现在正在研发Vision Pro,这副眼镜也会连接到Mac上。这两款设备之间的区别在于沉浸感的层次。原计划中的设备会使用半透明的镜片;拟议中的产品将采用Vision Pro的相同技术。

虽然目前尚未有关于这些产品何时发布以及是否会发布的官方消息,但苹果可能已经在为即将推出的束缚版产品所做的准备工作。

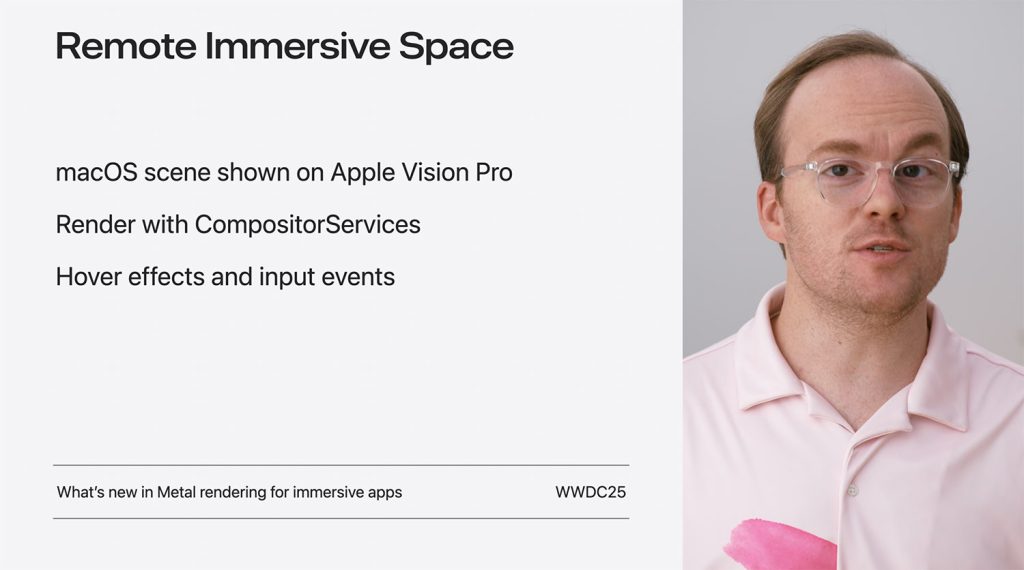

这是因为macOS Tahoe系统中首次实现26个应用可以直接在Apple Vision Pro设备上渲染三维沉浸式内容,利用了全新的场景类型。RemoteImmersiveSpace.

从macOS直连到视觉OS

This new capability was mentioned as part of SwiftUI’s evolving support for spatial computing, and it takes advantage of the fact that Apple is bringing the CompositorService与macOS Tahoe 26相关的框架。

该框架使运行在macOS tuhoo 26上的Mac应用程序能够直接将立体3D内容投射到Vision Pro环境中,无需单独构建visionOS版本。

用中RemoteImmersiveSpace现在,开发者可以利用SwiftUI创建沉浸式视觉效果,支持输入事件(如触碰和手势)以及空间交互的 hover 效果,从而让桌面应用能够完全融入沉浸式的环境。所有这些功能都可以在SwiftUI中实现,并且对于需要全面控制渲染的用户来说,还深入集成Metal框架,以确保完全控制绘制过程。

此外,SwiftUI团队还引入了强大的空间布局和交互API,使开发者能够构建体积式的界面,实现对象操作(如抓取虚拟水杯),并利用场景快照行为以创建更为动态的界面。

在实践中,这意味着一个macOS应用程序可以模拟完整的三维体验,从建筑设计的虚拟游览到科学可视化,并在Vision Pro上实时运行,由Mac提供动力。

结果如何?对希望试验Vision Pro或开始构建用于未来可能成为主流的空Computing的macOS开发者来说,准入门槛大大降低。

深入技术细节,请访问Apple的“SwiftUI更新概述”会话和……文档在苹果开发者网站上。